一个利用机器人和机器学习技术,用于温室番茄作物早期疾病和害虫检测的框架

1 介绍

21世纪的农业面临着一个关键挑战:开发创新且广泛适用的技术和方法,以满足快速增长的食物生产需求,同时解决气候危机和世界人口增长的后果。

温室和其他保护种植系统可以应对这些挑战,因为它们通过为作物提供遮蔽,防止不良天气和害虫,延长生长季节,节约用水和减少有害化学品的使用,从而提高产品产量和质量。然而,温室种植的广泛采用目前受到初始投资、能源消耗和劳动力等高成本的限制,同时管理养分供应、控制环境参数和减轻疾病和害虫的复杂性也在增加。因此,温室种植通常仅限于相对较少的高价值作物(例如番茄、黄瓜、辣椒和绿叶蔬菜)。

温室的结构化特性和受控环境促进了自动化技术和智能机器人系统的集成,以实现效率提升、减少对人工劳动力的依赖和成本,并优化植物生长与生产力。温室机器人能够协助或自主完成多种任务,包括种植、施肥和/或喷洒农药、授粉、作物监测与表型分析、数据收集,以及收获甚至修剪。此外,机器学习(ML)和其他人工智能工具已经在管理和分析从温室收集的复杂数据方面产生重大影响,以支持上述目标。

在此背景下,我们提出一个用于温室作物智能自动化监测的集成框架,旨在能够较早发现疾病和害虫。我们的目标作物是番茄,它是农业和全球粮食供应中最重要的作物之一,无论是在经济重要性方面,还是在营养价值与健康方面。该框架是在 SOUP 项目范围内开发的,结合使用机器人移动平台自主采集植物的多光谱图像,以及基于机器学习的工具来分析获取的图像,以检测潜在的害虫感染或疾病侵袭,以便采取适当和及时的行动来控制并根除它们。我们提出的框架的实现设计为易于在温室设施中部署,利用坚固且经过实地验证的组件。

本文其余部分组织如下:第二节概述相关工作。第三节描述了所提出框架的组件和技术。第四节展示实验结果,第五节进行讨论,而第六节提供结论性意见和对未来工作的建议。

2 相关工作

2.1 植物病害检测

害虫和植物病害的检测通常依靠人工和实践经验进行。相比之下,自动化检测可以成为更结构化流程的一部分,具有明显的优势。尽管面临各种障碍,叶片病灶检测仍存在受影响叶片与周围环境之间变化不明显、对比度差、病灶面积大小波动、图像噪声以及光照变化等问题。

使用手工特征的传统方法面临太多困难;而深度学习的出现则彻底改变了病虫害检测的状态。以下给出了一些典型方法。整体方法通过表征整个图像来进行描述是否包含病变。这类研究主要使用了卷积神经网络(CNNs),其中使用了叶片图像,或者将手机摄像头获取的图像输入到 ResNet 架构中。

局部检测方法通常旨在以边界矩形的形式定位病变。为此,已使用如 Faster R-CNN 等两阶段网络。在两阶段情况下,首先计算区域建议,然后使用相关特征图在 ROI 池化后对区域进行分类。在单阶段网络中,检测部分嵌入到骨干网络中,这简化了整体过程,比如使用 SSD 架构处理来自 17 个疾病类别的现场图像;另一种常用的架构是 YOLO,采用了 CNN:一个异常检测模型,验证输入图像是否有效(即包含占据图像适当部分的叶片);然后一个疾病识别模型检测输入图像中叶片上的病变并识别病变的可能原因。

当对病变进行完全分割时,可以提供更详细的信息,通常使用各种配置的全卷积神经网络。其他方法使用 Mask R-CNN 架构。然而,在大多数应用中,将病变作为边界矩形进行检测就足够了。

迄今为止,将此类方法集成到移动机器人平台上相对有限,因为假设采集主要由手完成,甚至更糟是在被背景分开的平坦叶片上,这给出了相当乐观的结果。在如何利用其他光谱通道(例如红外)的信息以及这是否有帮助方面,也有有限的工作。

2.2 温室作物监测机器人

为了有效部署开发的方法来监测作物中的植物健康,需要定期收集和分析作物中大部分植物的数据。

为此,一种有效的解决方案是将成像传感器安装在自主导航的移动机器人上,通过依次成像单株植物来收集数据。文献中已报道越来越多的此类系统,包括用于疾病/害虫检测或植物监测和表型的任务特定机器人,以及结合检测与靶向干预(如农药喷洒)的多功能机器人。由于许多目标植物(包括番茄)可以长到相当的高度,因此建议将成像传感器安装在可扩展平台或机械臂上,以实现有效和多功能的数据收集。

机器人平台的自主导航是自动化植物监测过程的关键前提。与露天作物基于卫星的 GNSS 导航不同,这种方式通常在温室内部不可行,因为温室常用的建筑材料(如玻璃、聚碳酸酯或塑料薄膜)会阻挡 GNSS 信号。因此,在温室内部导航需要采用替代的定位方法,例如室内定位系统(IPS)和传感器融合。IPS系统使用放置在温室周围的信标或标签,通过无线电波、红外线或超声波信号来三角测量机器人的位置。传感器融合方法依赖于激光雷达、深度相机和超声波测距仪等多种传感器的组合,并结合适当的算法来提供定位信息。然而,这种高级传感元件套件的成本仍然相对较高,而其长期运行可靠性可能会受到系统复杂性以及温室(主要是高温和湿度增加)的不利工作环境的影响。更简单但功能较少的解决方案涉及机器人平台沿固定路径移动,并结合某种形式的里程计来定位其在温室内的位置。 一个典型的例子是设计用于在作物行之间的现有供暖管道上移动的移动机器人。在温室内部固定机器人运动路径的其他方法包括使用光学线跟踪和附加的二维码标记来辅助定位,以及使用磁性引导传感器沿着铺设在地板上的磁带来运动。

3 框架组件和技术

我们提出的框架包含一套基于机器学习的图像分析工具来用于疾病检测,以及一个机器人平台来用于在温室内部自动收集数据。这些组件如下所示。

3.1 疾病检测工具

我们所提出框架中的集成疾病检测工具考虑了番茄植物的两个最重要的病害,即白粉病和番茄潜叶蛾。它们是利用机器学习方法和一个广泛的多光谱数据集开发的,具体描述如下。

多光谱数据集:我们的数据集包含 314 条记录,涵盖了本研究考虑的两种疾病。这些记录都标记了植物和感兴趣区域(RoI)。与文献中引用的大多数使用传统 RGB 相机捕获的数据集不同,我们公开可访问的数据集是通过多光谱相机获得的。此外,这些图像是在温室内部拍摄的,这减少了整个数据集中的环境变化。

数据集图像是通过Spectricon Muses9-ms-pl多光谱相机拍摄的。该相机配备4-6百万像素的C-MOS传感器,能够以每秒25帧的速度录制,覆盖370-1100 nm光谱范围。每台相机的拍摄会捕捉到总共8个通道,图像分辨率为1776×2368像素。该相机使用 USB3.0 接口。

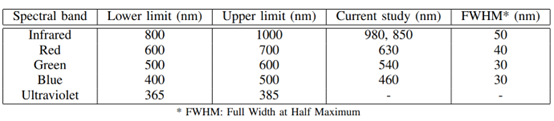

对于数据集中的每张图像,都提供了一个8通道的立方体。多光谱相机捕获的8个通道中,前三个通道是通过相机的 RGB 传感器获取的,而其余通道则通过多光谱传感器获得。对于这个数据集,选择了三个多光谱通道,分别为460nm(近蓝光)、540nm(近绿光)和630nm(近红光)。这些波段如表1所示。尽管多光谱相机选择的波长与 RGB 相机使用的波长相似,但多光谱传感器在这些频率上的响应比RGB相机更集中。具体来说这个数据集选择的多光谱通道中有三个分别为 460nm(近蓝光)、540nm(近绿光)和630nm(近红光)。此外,最后两个通道位于红外光谱区域,分别为850nm和980nm。

表1:MUSES9-MS-PL 相机支持的波长区域以及当前研究中使用的区域。

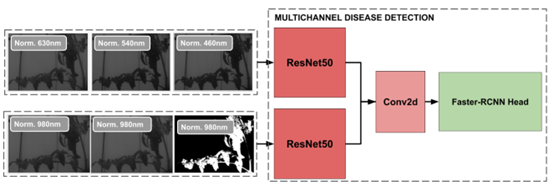

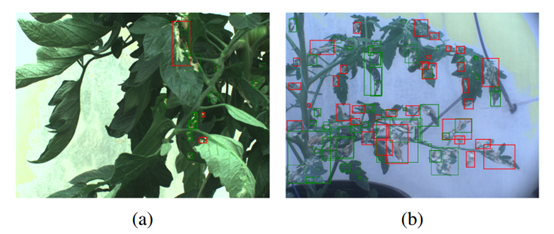

病灶检测:我们的病灶检测方法将其视为一个目标检测任务,因此我们采用了Faster-RCNN模型。我们使用了RGB通道和980nm波段,并结合了一个带有Faster-RCNN头的自定义模型。类似于,我们使用了两个相同的预训练骨干网络,一个用于处理RGB通道,另一个用于处理980nm波段。架构如图1所示。为了从输入中提取特征我们采用了两种ResNet架构,一个用于处理RGB通道,另一个用于处理980nm波段图像,然后使用一个基本的2D卷积层将它们结合在一起。得到的特征随后通过FasterRCNN头进行进一步处理。

图 1:多通道疾病检测模块。它接收 RGB 通道和 NIR 通道,将它们分别通过各自的 ResNets 提取特征,并通过卷积层后,通过 FasterRCNN 网络实现检测

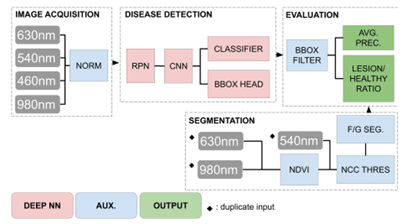

图 2 展示了整体处理流程。在图像采集后,基于其均值和标准差对光谱立方体进行归一化,以符合COCO数据集设定的先验,我们利用该数据集预训练模型。为处理误报,我们通过使用图像的NDVI指数裁剪出背景块,即仅保留叶绿素密度高的区域(分割步骤)。随后,归一化的光谱立方体被输入深度神经网络的检测流程。该流程生成边界框,表示为(x, y,宽度,高度),以及相应的分类分数。每个边界框定义了潜在病灶的边界。在最后一步,基于网络的置信度对生成的边界框进行过滤。

图 2:包括图像采集、背景分割、疾病检测和评估的整体处理流程。

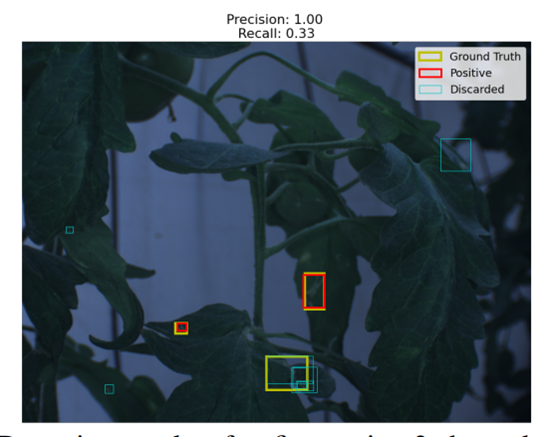

在参考文献中,最常用的评估指标是考虑分类精确度和召回率的指标,而对于检测部分则是基于目标与预测的交并比(IoU)。我们的任务更加精细,需要一种指标来正确测量每张图像的检测混淆矩阵。为此,我们设计了一种算法,将每个目标与其“最接近”的检测匹配。在该阶段之后剩余的所有缺陷都被计为假阳性。

3.2 机器人系统

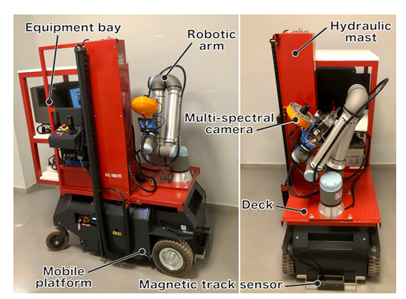

上述疾病检测工具被用作自动化温室管理集成系统的一部分,该系统采用图3所示的机器人平台。该机器人设计用于部署在温室作物中,以实现植物诊断数据的自动收集(本工作的重点)、通过喷洒进行植物保护以及水果的收获。

图 3:机器人平台。

在本次提出的场景中,温室机器人用于以系统的方式监测番茄作物通过定期从一致的角度采集植物的多光谱图像。图像自动上传到数据库,供疾病检测工具后续检索分析。

机器人平台:该机器人基于改装的商业垂直桅杆式移动平台(Bravi平台Leonardo HD)构建。选择这种特定车辆是基于其重型结构、良好的整体机动性、高达180公斤的大负载能力,以及将工作平台提升至离地面最高2.9米的能力。这一特点结合机械臂的可达范围,使得能够照料超出人类工人可达范围的植物,从而有可能通过允许植物比传统栽培长得更高,从而提高产品产量。差速转向车辆有一对驱动前轮和两个自由旋转的后轮。在其出厂配置中,移动底座由人工操作员通过手动摇杆驱动。为了实现其自动化运行,进行了一系列的改造和增配。改造完成后,车辆的移动以及垂直桅杆升降机的操作,现在都通过一台工业P(戴尔嵌入式 Box PC5000)控制,该PC运行ROS系统,并作为机器人的主要控制单元。

在导航方面,机器人采用磁导引系统,该系统由磁轨传感器(Roboteq MGS1600)和贴在地面上的磁带组成。传感器安装在移动底盘的前部(见图3),用于检测形成机器人预定路径的磁带,并利用PI转向控制律进行导航。地面上的附加磁标记有助于路径规划算法引导机器人到达特定通道中的单个植物。磁导引系统是一种可靠、经济且灵活的解决方案,被广泛应用于工业和仓库环境中的自动导引车(AGV)。为了确定机器人的位置,通过融合驱动轮电机上的增量编码器数据和安装在车辆底部的光学流传感器(Roboteq FLW100)的数据来获取里程计数据。

温室机器人配备了一台安装在垂直桅杆提升甲板前方的Universal Robots UR10e 6自由度机械臂,以方便进行辅助植物管理任务。UR10e机械臂非常适合这项应用,其工业级结构、1.3米的较大工作范围以及12公斤的高负载能力。此外,该机械臂兼容ROS,使其更容易与温室机器人的整体控制系统集成。

该机械臂的定制多功能末端执行器集成了Spectricon Muses9-ms-pl多光谱相机(即用于疾病检测工具开发的相机)用于植物监测,以及一台用于收获任务的深度相机(Intel RealSense D435)。多光谱相机直接连接到机器人的主控单元,而深度相机则连接到一个Nvidia Jetson Nano SBC,该SBC作为专用的视觉处理单元。

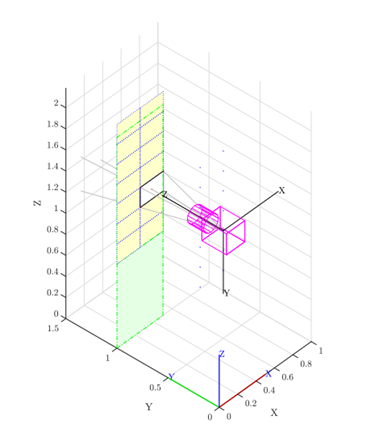

图 4:为植物成像指定多光谱相机定位而开发的 Matlab 模拟快照。

植物成像:要拍摄番茄植株,机械臂将相机定位在预定义位置以获取一系列多光谱图像。这些位置借助Matlab中开发的仿真工具确定(见图4),该工具利用机器视觉工具箱,基于以下简化假设:i) 相机的光轴始终垂直于拍摄平面,ii) 拍摄的植物与相机的距离处处相同,iii) 视场内没有因镜头或制造缺陷引起的畸变。算法的输入数据包括:i) 番茄攀爬植物的宽度和高度,ii) 相机与拍摄植物的平均距离,以及 iii) 所用相机的内参(焦距、垂直和水平视场、成像分辨率和像素尺寸)。算法的目标是确定图像平面到拍摄平面的映射关系,进而计算末端执行器所需的水平和垂直增量位移。

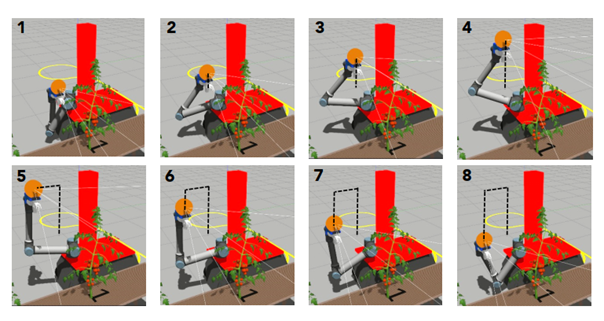

机器人以两列的方式对每株植物进行侧面拍摄,末端执行器以Π形子模式移动(见图5),子模式的高度可延伸至四个图像采集位置,基于机械臂的可达范围。如果植物更高,则升起提升平台,并获取新的子模式。对于每个成像位置,通过求解机械臂的逆运动学来保持相机方向与地面平行。数据库:多光谱相机捕获的植物图像被压缩并上传至已设置为亚马逊网络存储服务器的云数据库。同时,数据库中添加相应的条目,以将收集的数据与相应的植物及其在温室内的位置相关联。然后,通过第四节A中介绍图像分析工具检索图像,以检测和识别潜在病害。

图 5:植物检查程序的Gazebo仿真,涉及从8个位置沿Π形图案获取一系列多光谱图像。

4 实验结果

4.1 疾病检测工具

在希腊赫拉克利翁的希伦尼科斯地中海大学(HMU)的实验温室设施中,于秋季对开发的疾病检测工具进行了评估。将Solanum lycopersicum var. ELPIDA 品种的番茄幼苗在四片真叶阶段移植到岩棉板上,这些岩棉板放置在覆盖着聚乙烯薄膜的不供暖的双跨拱形温室中。

为了产生人工的潜叶蛾侵害,从一个当地商业温室收集的昆虫中开始建立群体,并在实验室(25℃;湿度 75 ±5%;12 小时亮:12 小时暗)中通过喂食番茄植物维持四周。八周后,成虫被移入实验温室内的两个防虫室中。随后,十二株无感染、九片完全发育的叶子的番茄植株每平方米被三个成虫侵害。要制备人工白粉病菌感染,从当地商业温室中生长的番茄植株幼叶中分离出霜霉菌。通过用水强烈清洗感染叶片来收集分生孢子。

处理完成后,番茄植株每天使用标准营养液进行施肥,该营养液根据计算得出,并使用自动营养混合系统。在人工接种和定殖两周后,每三天使用多光谱相机对番茄植株进行采样。

我们使用了基于 Pytorch 的 Faster-RCNN 实现,其骨干特征提取器在ImageNet上预训练,而整个网络在COCO’17上预训练。从该初始模型开始,我们继续在验证控制约束下进行训练。具体来说,当验证损失达到第一个局部最小值时,我们停止训练,容忍度为其最后值的5%。

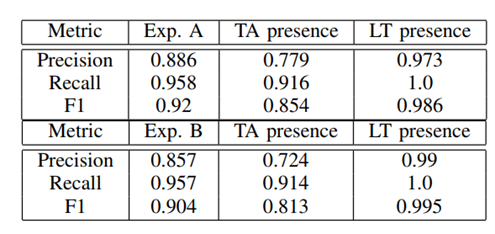

为了评估使用近红外通道的好处,我们进行了两个实验。第一个实验,称为A,将630nm、540nm和460nm的三个通道作为预训练Faster-RCNN模型的输入。在第二个实验,B中,我们创建了一个具有两个并行骨干的修改架构,以整合一个我们将另外三个通道加入我们的输入。使用的通道是 850 nm,980 nm和阈值化的NDVI,第三个通道作为立方体叶片面积掩膜。指示结果如图6和图7所示,表2总结了我们的发现。可以看出,所开发的方法在检测这两种病害方面取得了非常好的整体性能。关于多光谱波段的使用,结果表明仅在LT情况下有积极影响。然而,需要进一步实验以更全面地理解它们的优势。

图6:使用Faster-RCNN的检测结果 (a),(b)。红色框表示得分超过 98%的边界框。

图7:微调 3 个通道后的检测结果:630 nm,540 nm,460 nm。

表 2:实验 A 和 B 的检测结果。在此,图像中存在疾病被视为成功检测。为提高准确性,我们采用了五折交叉验证方法,并对获得的结果进行平均。

4.2 集成系统的实验

我们在此展示在实验室环境下进行的实验结果,旨在评估所提出的机器人疾病检测框架。实验在学校工程学院的建筑走廊中进行。在3.2米宽的走廊两侧,安装了一排9株植物(即总共18株),这些植物被放置在金属提升式排水沟上,配置方式模拟了典型水培番茄温室中两排植物的排列。所有植物的高度和相对于固定参考框架的位置事先已知。这些番茄植株在 HMU 农业系的温室设施中通过水培方式种植,根部置于生长袋中。其中14株植物健康状况良好,其余4株被有意感染。感染包括两种Tuta absoluta病例和两种Leveillula taurica病例。

机器人通过地板中间位置放置的磁带来引导行进。使用里程计数据在特定位置停止机器人,并用多光谱相机扫描走廊两侧的植物,然后移动到下一对植物(图 8)。完整地拍摄走廊中所有 18 株植物大约需要 35 分钟完成。

图 8:机器人平台实验的摄影实例

在两天内总共进行了四次这样的运行以确保全面的数据收集。每天进行两次运行,植物在运行之间颠倒以捕捉两侧的图像。值得注意的是,所有四次运行都成功完成,未遇到任何问题或复杂情况。

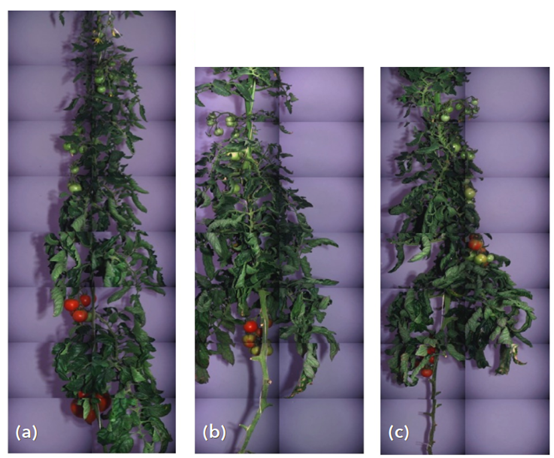

图 9 提供了指示性结果,展示了通过拼接使用多光谱相机获取的图像重建的三个番茄植株。请注意,与植株(b)和(c)相比,植株(a)获取的图像数量更多(16 张 vs 14 张),因为它更高。

获取的图像集随后被检索从数据库中进行分析,检测算法能够正确识别感染植株及其具体病症,且无假阳性(即所有健康植株均被正确识别为健康)。

图 9:通过拼接实验期间使用多光谱相机拍摄的图像,获得的番茄植株重建示例。

5 讨论

总体而言,开发的疾病检测工具在实际场景中证明非常有效,能够识别受感染的番茄植株。我们的结果表明,与传统的RGB图像相比,使用多光谱图像并未带来显著优势,但显然需要更多实验来探索替代的深度架构。

关于集成系统,目前的一个限制是单株植物成像所需时间的增加,每侧植物的时间范围在80到150秒之间(取决于植物高度)。这其中的主要瓶颈是大型的多光谱图像文件的获取、打包和上传到数据库,每张图像大约需要8秒。升级到更新、更高效的相机,并优化光谱波段配置,预计将在这方面带来显著改进,这对系统的实际应用具有重要意义。

在考虑该系统在田间应用时,还应指出,不必检查每一株植物来确定作物是否感染了任何已训练的疾病。在单株植物图像中检测到感染叶片就足以发出潜在作物感染的警报,并促使采取适当措施。根据所选的植物保护策略,这可能涉及实施全田预防性喷洒或针对受影响植物实施定点干预。

6 结论

我们已提出一个利用机器人和机器学习技术进行温室番茄作物病虫害检测的框架。我们的实验证明了检测的准确性以及机器人平台自动化系统性地执行植物成像任务的能力,且无需依赖人工。计划在实际温室中进行测试,以对系统进行更具应用导向的评价。

此外,目前已实施额外的图像分析工具,以增加从植物成像数据中提取的有用信息量,包括植物生长率的估计以及番茄果实检测和成熟度评估。

最后,开发的框架可以通过利用相同的机器学习方法和工具,方便地扩展到其他温室作物,如辣椒或茄子,以检测这些作物特有的病虫害。结合集成到机器人系统中的农药喷洒和果实收获的附加功能,该系统可作为多功能且经济高效的平台,用于各种温室作物的智能化自动化。

摘自:Nikolaos Kounalakis, Emmanouil Kalykakis, Dimitrios Kosmopoulos,John Fasoulas, and Michael Sfakiotakis:A framework leveraging robotics and machine learning technologies for early disease and pest detection in greenhouse tomato crops

转在的目的在于传递更多的知识,如有侵权行为,请联系我们,我们会立即删除。